このブログを動かしている Ruby を 3.1 系から 3.2 系にアップデートした。

ネックになっていたのが tantiny で、オリジナル開発者の baygeldin 氏が自分でこの gem を使わなくなったようでメンテナンスされなくなっており、 fork してなんとか Ruby 3.1 対応までできていたが、 tantiny が依存する rutie が Ruby 3.2 以上に対応できておらず、にっちもさっちもいかなくて困っていた。

そんななかリポジトリを覗いてみると、 2025 年の 11 月に新しいメンテナーが見つかって Ruby 3.x に対応したバージョンがリリースされていた。

最新バージョンの 0.4.2 を入れてみたところ、 Ruby と Rust のブリッジは rutie ではなく magnus を使うようになっており、問題なく動くようになった。

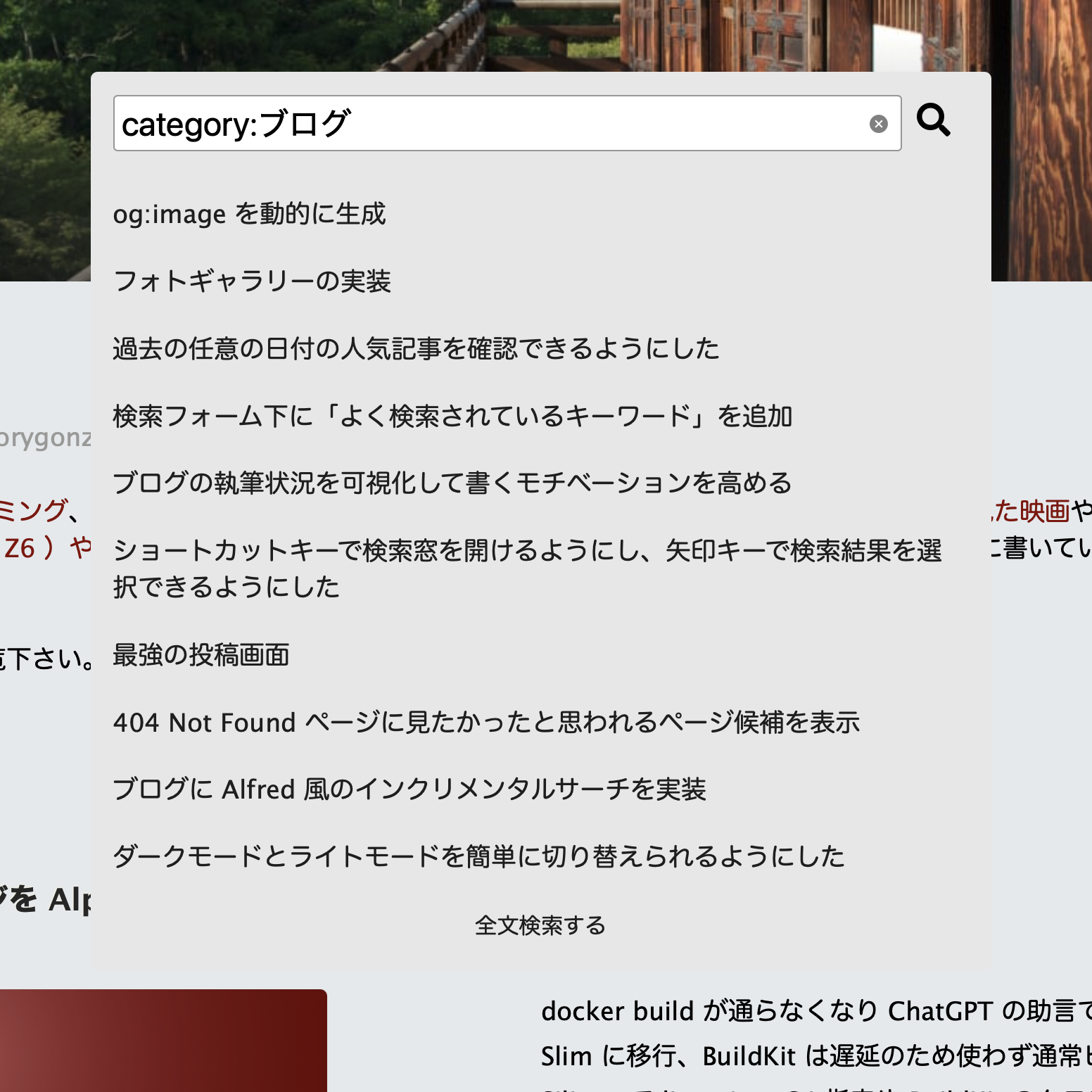

tantiny の新しいメンテナーが現れているのを知らずに tantiny を捨てて MySQL の FULLTEXT インデックスで代替しようかと試みたが、検索精度が低いのとパフォーマンスも劣化してしまって途方に暮れていた。このブログに書いていることは自分の脳みその 30% くらいの領域を占めているので、精度が高く高速にレスポンスを返す全文検索が使えなくなってしまうとだいぶ困る。新しいメンテナーは会社のようなので tantiny はちゃんとメンテナンスされそうだ(元 Algoria のスタッフがやってる会社みたい)。ありがたや。