ATOK がサブスクリプションを始めて結構経つが、自分は相変わらず 3 年おきくらいにパッケージ版を購入して利用する使い方を継続していた。最後に購入したのは ATOK 2014 で High Sierra くらいまではインストールして使えていたが、 Mojave でとうとうインストーラーが不正と出てインストールできなくなってしまった。最後のパッケージ版の ATOK 2017 for Mac を買うかサブスクリプションに加入するか迷ったが、迷っている間にパッケージ版の販売が終了しており、仕方なく ATOK Passport に加入した。

ATOK 2014 時代に便利だったのが ATOK から Mac の辞書やカレンダーを参照する機能( Mac スマート連携)で多用していた。 ATOK Passport プレミアムに移行したところ、広辞苑やウィズダム英和・和英辞典(クラウド電子辞典)は使えるが、 Mac の辞書やカレンダーの内容を検索する機能はデフォルトで使えない状態だった。「 Mac スマート連携をオンにしますか?」というダイアログが出たときに「はい」を選択したので十分だと思っていたが、そうではないようだった。以下の通り Mac の辞書で検索されていないことがわかる。

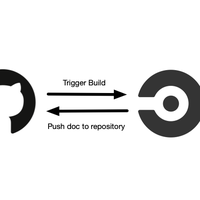

実際にはプラグインとしてインストールが必要のようだった。ただググったときに出てくる以下のやり方は旧バージョンの情報で、最新の ATOK Passport では機能しない。

正しくは以下のページに書いてあるが、 JUSTオンラインアップデート というアプリを起動し、プラグインをインストールしていく必要がある。

その上で ATOK の環境設定を開き、「電子辞典検索」の項目から「追加」を押して、入力時に参照する辞書に「ATOKダイレクトビュー for 辞書」や「ATOKダイレクトビュー for カレンダー」などを追加していく必要がある。めっちゃわかりづらい。

ここまで設定してようやく Mac の辞書で検索されるようになった。

ATOK の日本語変換の精度は好きだし「今日」と打ってその日の日付に変換できるところなど機能自体は便利なのだけど、 UI が特殊すぎたり、設定が複雑だったり、公式サイトのドキュメントの情報が古すぎたりで総合的な使い勝手がよくない。これではパソコンに詳しくない層には使いこなせないと思う。